Spätestens seit Trumps Wahlsieg sind Fake-Nachrichten und Meinungsbots eines der heißen politischen Themen des Herbstes. So wichtig, dass die Bundeskanzlerin Merkel in der Generaldebatte zum Haushalt dem Thema einen Absatz widmet. Doch ihre Rede zeigt auch, dass in der Debatte vieles durcheinander geht: Die Menschen würden heute Medien wahrnehmen, die auf anderen Grundsätzen als der Sorgfaltspflicht basierten und weniger kontrolliert seien. Dabei würden Fake-Seiten, Bots, Trolle und Algorithmen Meinungen verfälschen oder verstärken. Dies müsse notfalls geregelt werden. Und weil das ja nicht schon genug voneinander zu trennende Phänomene sind, vermengt die Kanzlerin das sogar noch mit der Hatespeech-Debatte. Dass eine Regelung dieser Phänomene sich negativ auf die freie Meinungsäußerung und andere Grundrechte auswirken kann, zeigt nicht nur, dass China die Debatte um falsche Nachrichten dankbar aufgreift.

Es ist also höchste Zeit für eine Begriffsklärung. Wir wollen deshalb mal die gängigsten Formen von falschen und echten, von menschlichen und automatisierten Profilen und ihre Rolle in der Meinungsbeeinflussung vereinfacht darstellen – und voneinander trennen. Dabei geht es absichtlich nicht nur um maschinelle Social-Bots, da auch manuelle Fake-Accounts eine große Rolle in der Meinungsbildung spielen können. Letztere zeigen auch, dass die Phänomene nicht alle neu sind, sondern den medialen Alltag schon lange begleiten. Um das Thema greifbar zu machen, werden die einzelnen Fälle anhand von Beispielen erklärt.

- Bots

- Bot-Netze

- Menschliche Fake-Accounts

- Maschinelle Fake-Accounts

- Trolle

- Trollarmeen

- Chat-Bots

- Spam-Bot

- Meinungsbots

- Fake-News

- Lösungsansätze

Was ist ein Bot?

Das Wort „Bot“ ist eine Kurzform des englischen Wortes Robot (Roboter). Ein Bot kann ein Computerprogramm sein oder auch ein maschinell gesteuerter Social-Media-Account. Bots erfüllen automatisiert bestimmte Aufgaben. Der Text widmet sich hauptsächlich Chat-Bots und Social-Bots wie Spambots und Meinungsbots. Andere Arten von Bots werden nur am Rande behandelt.

Bots können sehr praktisch und völlig legitim sein. Der Twitter-Account @netzpolitik_org ist ein einfacher Bot. Er überprüft in regelmäßigen Abständen, ob auf netzpolitik.org neue Artikel veröffentlicht werden. Wird ein Artikel veröffentlicht, nimmt er sich die Überschrift und das Artikelbild und postet diese auf dem Twitter-Account.

Während unser Bot manuell angelegt und dann mit einer Automatisierung versehen wurde, werden die meisten Social-Bots halb- oder vollautomatisiert erstellt. So lassen sich große Stückzahlen zu einem niedrigen Preis produzieren. Wer Bots benutzen will, kann sich diese entweder selbst erstellen oder auf dem freien Markt kaufen. Der Bot kann mit Informationen wie Profilbild oder Biografie-Text angereichert werden, er kann anderen Accounts oder Bots folgen – oder loslegen mit den Aktionen, die in sozialen Netzwerken automatisiert ansteuerbar sind.

Bots werden also über Skripte/Software erstellt und gesteuert. Eine einfache Aufgabe könnte sein: Twittere Überschrift und Link zum Artikel aus den Medien A, B und C immer dann, wenn die Überschrift das Wort „Merkel“ enthält und versehe den Tweet mit dem Hashtag #merkelmussweg. Oder: Stelle bei Account XY eine Freundschaftsanfrage. Oder: Like diesen Facebook-Post. Denkbar sind natürlich auch deutlich komplexere Programmierungen oder Aktionen sowie der Einsatz künstlicher Intelligenz und die Interaktion mit echten Menschen.

Bot-Netz

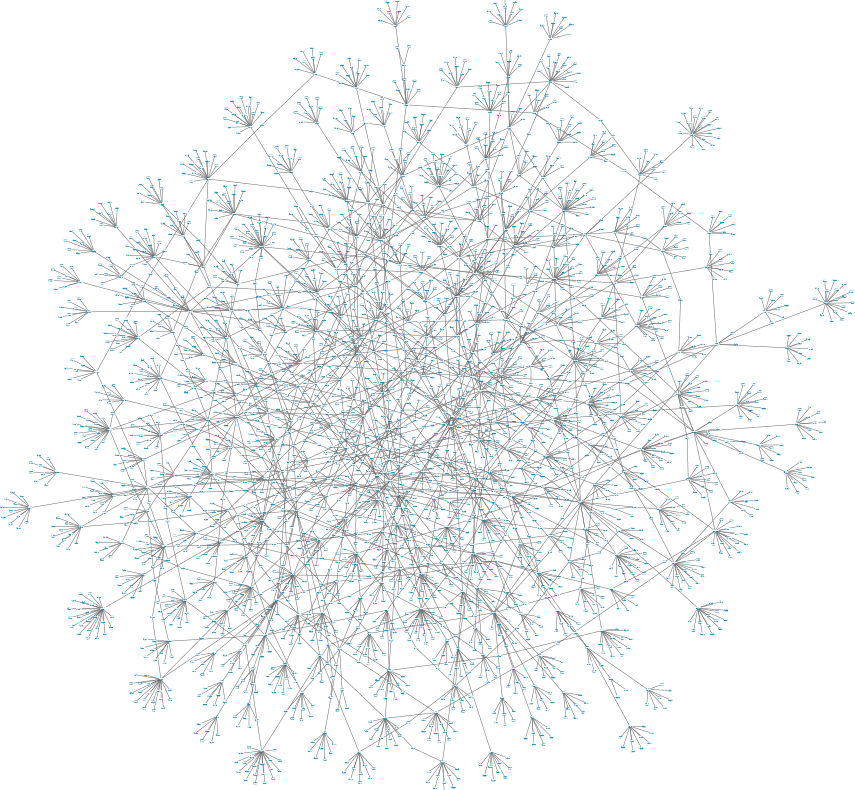

Ein Botnetz ist ein Netzwerk von Bots, die zusammen agieren. In sozialen Netzwerken sind Botnetze miteinander verbundene automatische Accounts, die sich meist gegenseitig folgen und ihre Inhalte gegenseitig weiterverbreiten können. Sie können aus tausenden Einzelaccounts bestehen, die von nur einer echten Person gesteuert werden. Bots sind besonders häufig auf Twitter zu finden, können aber in allen sozialen Netzwerken existieren. In einem Bot-Netz können dann tausende von Bots Aktionen ausführen, wie Hashtags retweeten oder bestimmte Postings auf Facebook liken.

Der Begriff Bot-Netz wird häufig für gekaperte Computer benutzt, die zum Beispiel Spam versenden oder DDoS-Angriffe fahren, um zum Beispiel Onlineshops zu erpressen. Diese haben aber nichts mit den Social Bots zu tun, die jetzt diskutiert werden.

Menschliche Fake-Accounts

Momentan reden alle von Bots. Es gibt es auch jede Menge manuell erstellte Fake-Accounts in sozialen Netzwerken, Communities und Foren. Während Pseudonymität eine weit verbreitete und wichtige Kulturpraxis für Privatpersonen ist, kann sie von PR-Agenturen und anderen gesellschaftlichen Playern für intransparente Meinungsbeeinflussung sowie von Trollen für Belästigung genutzt werden.

Pseudonyme Accounts

Eine sehr übliche und weit verbreitete Form von Accounts unter anderem Namen sind pseudonyme Accounts. Hier melden sich Menschen mit einem anderen als ihrem echten Namen an. Es gibt gute Gründe für Pseudonymität: sie schützt Menschen und Minderheiten vor Belästigung und Schikane sowie Aktivistinnen und Aktivisten vor Verfolgung. Pseudonymität ist essenziell für die Meinungsfreiheit, da sich niemand vor seinem Arbeitgeber, der Familie oder anderen mit seinem echten Namen verantworten muss. Dies nimmt den Druck zu Konformität und Normierung heraus, weil die Leute „frei Schnauze“ schreiben können.

Zweitaccounts / Rage Accounts

Bei dieser Form handelt es sich um einen pseudonymen Account einer Person, die mit einem anderen Account im jeweiligen Netzwerk oder Forum (eventuell auch mit Klarnamen) bekannt ist. Weil die Person unter dem bekannten Account zu sehr auf ihre Reputation achten muss und sich in ihrer Meinungsfreiheit eingeschränkt fühlt, richtet sie sich den pseudonymen Account ein, mit dem sie machen kann, was sie will. Der Rage Account ist hierbei eine Sonderform. Weil es hier um Wut geht, kann er Überschneidungen mit dem Troll haben.

Sockenpuppen

Hierbei handelt es sich in erster Linie um Zweit- und Drittaccounts, die mit dem Ziel erschaffen werden, um in Wikis und anderen Communities, die Meinungsbildung zu beeinflussen. Die Sockenpuppen verstärken sich in Entscheidungsprozessen selbst und lassen die Diskussion so aussehen, als würden mehrere Personen eine ähnliche Meinung vertreten. Das Phänomen ist auch in den Kommentarbereichen in Blogs bekannt.

Fake-Accounts in der Kommunikationsguerilla

Eine weitere Spielart sind Fake-Accounts bei Aktionen der Kommunikationsguerilla oder bei Satireaktionen. Hierbei werden oftmals prominente Personen oder Firmen imitiert und dabei die Öffentlichkeit in die Irre geführt. Das Verifikationssystem von Twitter hat diese Spielart der Desinformation erschwert. Diese Fake-Accounts sind zu unterscheiden von als solchen gekennzeichneten Parodie-Accounts.

Eierköpfe

Wer sich bei Twitter als Troll betätigen will, klickt sich schnell einen Account. Der rohe Account hat bei Twitter ein Ei als Profilbild. Viele Trolle und Hater erkennt man an wenigen Followern und einem Ei als Profilbild. Da rechte Trolle dies häufig nutzen, etablierte sich auch schon mal der Hashtag #besorgteEier.

PR-Accounts & Astroturfing

Die Arbeit mit Fake-Accounts ist in der Public Relations zwar verpönt und widerspricht selbstgegebenen Leitlinien von PR-Verbänden, gehört aber immer noch zur Praxis der Branche. Einen kleineren Fall beschrieb der Tagesspiegel. Die Zeitung verdächtigte den Unternehmer Carsten Maschmeyer, mit Fake-Profilen ihn positiv darstellende Kommentare unter einem Interview zu hinterlassen.

Besonders augenscheinlich wurden solche Methoden zum Beispiel bei den Auseinandersetzungen um Stuttgart 21 genutzt. Hier arbeiteten PR-Agenturen mit falschen Profilen und falschen Blogs, um den Anschein einer Bürgerbewegung für das Bauprojekt zu erwecken – während eine echte Bewegung mit zehntausenden Menschen auf der Straße dagegen demonstrierte. Weitere Werkzeuge beim so genannten Astroturfing sind falsche Leserbriefe, Änderungen von Wikipedia-Artikeln oder auch Kundenbewertungen. Es handelt sich bei diesen Methoden um eine verdeckte Beeinflussung der Öffentlichkeit unter Nutzung von falschen Profilen. Heute können für das Astroturfing auch Meinungsbots genutzt werden.

Automatisiert erstellte Fake-Follower und Fake-Accounts

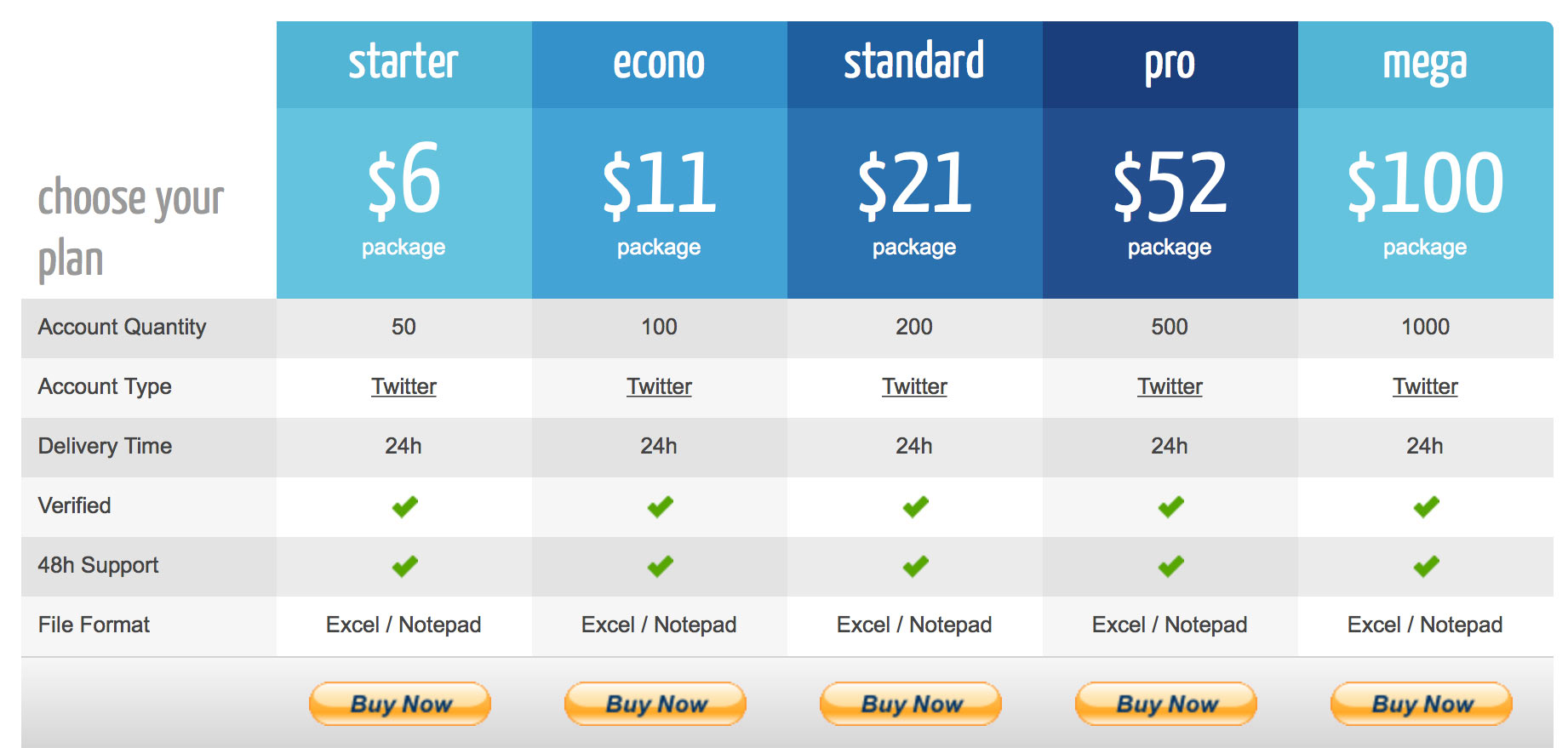

Ob Tumblr, Facebook, Twitter oder Instagram: Fake-Profile aller sozialen Netzwerke sind im Internet für Geld frei erhältlich. 1000 falsche Twitterprofile kosten ab 40 Dollar aufwärts. Dafür gibt es allerdings nur die so genannten „Eierköpfe“: Profile ohne Profilbild und ohne Follower.

Will man gereifte Profile kaufen mit Followern, Biografien, Profilbildern und Tweets muss man deutlich mehr Geld hinlegen. Je höher die Qualität und damit die Glaubwürdigkeit der Profile, desto teurer sind die Fake-Accounts. Die Preise können bei richtig guter Qualität schon mal 100 Dollar für einen einzigen Facebook-Account erreichen. Die gekauften Fake-Accounts können, sofern sie steuerbar sind, als Meinungsbots eingesetzt werden. Hierzu werden sie mit Skripten in ihrem Verhalten gesteuert.

Doch nicht nur Accounts sind käuflich, sondern jede Form von Interaktion oder Gefolgschaft in sozialen Netzwerken. Im Gegensatz zu voll steuerbaren Accounts, gibt es auch Follower, Facebook-Likes, Youtube-Views für wenig Geld zu kaufen. Diese werden einmalig gekauft und erhöhen die vermeintliche Relevanz von Accounts oder die Sichtbarkeit von Inhalten oder Seiten. Für die wirkliche Relevanz eines Twitter-Accounts sind inaktive, gekaufte Fake-Follower übrigens kaum nützlich. Sie täuschen nur Relevanz vor, tragen aber langfristig nicht zur Verstärkung eines Accounts bei, weil sie keine Interaktionen auslösen.

Soziale Netzwerke und Plattformen versuchen die automatisierte Erstellung von Accounts zu erschweren. Dies geschieht zum Beispiel durch Telefonverifikation und Captchas und führt dazu, dass für die Erstellung oder bestimmte Prozesse so genannte „Mechanical Turks“ genutzt werden: einfache, billige menschliche Klickarbeiter, die Captchas lösen oder Aufgaben erledigen, die sich nicht maschinell lösen lassen.

Trolle

Als Troll bezeichnet man eine echte Person, die in der Netzkommunikation durch Provokation, Störung, Beleidigungen und schiere Häufigkeit der Kommunikation auffällt. Trolle können auf Twitter Hashtags kapern, in den Kommentarbereichen von Medien Diskussionen erschweren, auf Facebook blöde Fragen stellen. Hier ist jede Art von Störung denkbar. Trolle agieren in ihrem echten Namen, im Namen anderer, unter Pseudonym oder auch anonym. Der Troll gehört schon immer zum Internet. Er ist ein lästiges aber bisweilen auch unterhaltsames Phänomen.

Troll-Armeen

Der Begriff Troll-Armee wurde bislang nur für eine russische Desinformationsstrategie genutzt. Das greift aber zu kurz, denn ähnliche Vorgehensweisen gibt es auch in anderen Zusammenhängen. Kennzeichen von Troll-Armeen war bislang, dass echte Menschen die Aktionen koordiniert ausführen. Hier wird der Mensch selbst zum Bot, der Handlungsaufrufe und Befehle erhält. Dies kann sich jedoch heute auch mit dem Einsatz von maschinellen Bots vermischen.

Es gibt zwei Hauptformen von Troll-Armeen:

1) Koordinierte Aktionen von in Interessensgruppen vernetzten Einzelpersonen

Ein Beispiel wäre: In einem Forum oder einer Facebook-Gruppe von Waffenbesitzern verabreden sich die Mitglieder, einen Bericht zur Verschärfung des Waffenrechts mit Kommentaren zu fluten. Sie wollen damit den Eindruck zu erwecken, dass die öffentliche Meinung gegen eine Verschärfung des Waffenrechtes ist. Ein anderes Beispiel wäre: Mitglieder einer Partei rufen in ihren Gruppen, über Mailinglisten oder auf Twitter dazu auf, bei einer Online-Umfrage auf einer Zeitungswebseite durch massenhafte Teilnahme ein bestimmtes Umfrageergebnis herzustellen. Eine Sonderform dieser Spielart der Troll-Armee sind die Aktionen („Raids“) die von Usern der Seite 4chan ausgehen. Bei diesen Varianten der Troll-Armee können echte Profile, Fake-Profile, pseudonyme Profile und anonyme Postings genutzt werden.

2) Koordinierte Aktionen von Interessensgruppen, die dafür Menschen bezahlen und/oder anstellen

Eine Regierung stellt eine Agentur an, die koordiniert in Kommentaren auf Medienseiten oder in sozialen Medien die Position der Regierung vertritt oder Kritik an der Regierung zerstreut. Im Fall Russlands beschreibt dieser Wikipedia-Artikel dieses Vorgehen detailliert. China nutzte eine ähnliche Strategie mit der „50-Cent-Army“, die Kommentare im Sinne der kommunistischen Partei verfasste. Auch bei der US-Armee und dem britischen Geheimdienst GCHQ gibt es Programme, die Strategien von Troll-Armeen nutzen. Im Fall der US-Armee wurde schon 2011 bekannt, dass dort mit Fake-Accounts, falschen Kommentaren und Blogs auf die öffentliche Meinung Einfluss genommen werden sollte. Beim GCHQ ging es im Programm unter anderem um gezielte Rufmordkampagnen, die durch Postings von Fake-Accounts durchgeführt werden.

Eine weitere Spielart, die in unseriösen Zweigen der Public Relations vorkommt, ist die Beeinflussung von Diskursen durch PR-Mitarbeiter unter falschem Namen. Hierzu gehören positive Produktbeschreibungen für den Kunden, die Zerstreuung von Kritik oder wie beim Astroturfing, die Simulation von Bürgerbewegungen.

Bei all diesen Vorgehen wollen die Urheber immer den Eindruck erwecken, dass hier echte Menschen eine Meinung vertreten. Weil aber keine echten Menschen verfügbar sind, wird vorrangig mit Fake-Profilen gearbeitet.

Chat-Bots

Chat-Bots werden heute zum Beispiel in der Kundenbetreuung eingesetzt. Ein Beispiel wäre: Ein Energieversorger bietet auf seiner Webseite einen Chat-Bot an. Dieser ist gefüttert mit den am Häufigsten gestellten Fragen. Ich will nun als Kunde wissen, wie ich den Stromzähler ablese. Ich frage: „Wie lese ich den Stromzähler ab?“ – Darauf gibt der Bot mir die richtige Antwort. Stelle ich eine Frage, die der Bot nicht beantworten kann, gelange ich auf die nächste Ebene des Kundensupports und werde mit einem menschlichen Kundenbetreuer verbunden. Meine nicht beantwortbare Frage fließt eventuell in die Verbesserung des Chat-Bots ein, damit dieser beim nächsten Mal die Frage beantworten kann. Unternehmen versprechen sich vom Einsatz dieser Chat-Bots, die mittlerweile auch in Telefonhotlines einsetzbar sind, eine Senkung der Personalausgaben.

Ein schönes Beispiel im politischen Betrieb ist der virtuelle Adler von bundestag.de. Diesem Chat-Bot können Nutzer zahlreiche Fragen stellen, die er auch beantworten kann. Chat-Bots werden auch auf Datingportalen eingesetzt. Da Männer dort überrepräsentiert sind, versuchen unseriöse Portale die schlechte Frauenquote mit Chat-Bots und Fake-Profilen auszugleichen. Die Bots sollen hier die Männer beschäftigen, damit diese auf der Plattform bleiben und weiterhin bezahlen.

Bei Chat-Bots wird vermehrt auch künstliche Intelligenz eingesetzt. Die großen Internetkonzerne wie Apple, Google und Amazon arbeiten hier mit Siri, Google Assistant und Alexa an ausgefeilten Lösungen. Ein Trend der Chat-Bots ist, dass sie immer mehr in den Bereich der Instant-Messenger drängen.

Spam-Bots

Es gibt unterschiedliche Typen von Spam-Bots in sozialen Medien. Spam-Bots auf Twitter setzen sich in den meisten Fällen auf häufig genutzte Hashtags und posten dann, oftmals völlig themenfremd, ihre Werbenachrichten. Sie sind lästig, weil sie Hashtags verschmutzen und unbenutzbar machen. Eine andere Form des Spam-Bots postet so genannte @mentions (Erwähnungen) an Personen und versucht damit die Nutzer zum Klick auf einen Link zu bewegen.

Besonders erfolgsversprechend und intelligent ist diese Form des Spams nicht, auch sind die meisten Spam-Bots sehr schnell enttarnt und werden von Nutzern als Spammer gemeldet. Die Plattformen gehen recht rigoros gegen die auffälligen Spam-Bots vor.

Meinungsbots & automatisierte Propaganda

Um Meinungsbots, Social Bots oder „automatisierte Propaganda“ geht es hauptsächlich in der Debatte nach der Trump-Wahl. In der Wahl wurden diese intensiv vor allem von Trump, aber auch vom Clinton-Lager eingesetzt.

Das Forschungsprojekt Politicalbots.org beschreibt das Phänomen so:

„Der Begriff automatisierte Propaganda, oder auch computergestützte Propaganda, bezieht sich auf politische Desinformation oder Belästigungskampagnen auf Social-Media-Plattformen. Sie passiert häufig auf Plattformen wie Twitter und Facebook und wird durch die Nutzung softwarebasierter, automatisierter Bots betrieben. Dabei werden Accounts genutzt, die wie echte Menschen aussehen, die Inhalte produzieren und mit echten Usern interagieren. Politische Bots werden weltweit von Regimes und anderen politischen Akteuren als Instrument eingesetzt, um massiv und rechnergestützt Journalisten zu bedrohen, Kommunikation von Aktivisten zu stören und um Propaganda zu verbreiten, mit dem Ziel die öffentliche Meinung zu manipulieren.“

Bots und Botnetze können durch ihre schiere Anzahl und durch ihre Aktivität die „Trending Topics“ von sozialen Netzwerken beeinflussen oder die Sichtbarkeit bestimmter Inhalte oder Accounts verstärken.

Simon Hegelich, ein Wissenschaftler der zum Thema arbeitet, hat ein ukrainisches Bot-Netz untersucht und bei der Adenauer-Stiftung eine kleine Publikation zum Thema Social Bots veröffentlicht. Er beschreibt unterschiedliche Verhaltensweisen von Meinungsbots:

- Verschleierung: Das Posten scheinbar belangloser und normaler Inhalte

- Attraktion: Inhalte für Zielgruppen wie Nachrichten oder Downloadlinks, die Menschen suchen

- Verstärkung: Verbreitung von Hashtags und Propagandanachrichten

Insbesondere die „Verstärkung“ durch Bots kann durch die Berichterstattung von Medien („Auf Twitter trendete Kandidat XY“) noch einmal multipliziert werden. Zudem können Meinungsbots, wie Spam-Bots oder Troll-Armeen, existierende Hashtags kapern. In diesem Falle mit dem Ziel diesen mit anderen Inhalten zu füllen, ihn unbenutzbar zu machen oder gar im Sinne des Steuernden komplett zu übernehmen.

Möglich sind aber auch Bots, die auf bestimmte Aussagen mit bestimmten Antworten reagieren. So könnte ein Bot auf einen Tweet „Ich wähle XY“ antworten: „Willst du wirklich XY wählen? XY ist in diesen Skandal verwickelt, siehe Link“. So können und tausendfach automatisiert Zweifel an Kandidaten gesät werden. Auf dem Kongress des Chaos Computer Clubs 2014 zeigten Forscher im Vortrag „Mein Bot, der Kombattant“ nicht nur die Grundlagen des Informationskriegs, sondern präsentierten auch einen Bot, der auf russlandkritische Aussagen mit russlandfreundlichen Äußerungen reagierte.

Die Enthüllungen von Edward Snowden zeigten, dass der britische Geheimdienst GCHQ Meinungsbots für den Informationskrieg nutzt: Zum Programm der Joint Threat Research Intelligence Group (JTRIG) gehören die Manipulation von Online-Umfragen, das künstliche Aufblasen von Zugriffszahlen auf Webseiten und die Erhöhung von Zugriffszahlen von Videos (Views) auf Portalen wie YouTube.

Dabei müssen die Betreiber von Botnetzen natürlich immer aufpassen, dass die Bots nicht zu eindeutig als Spammer oder Bots auftreten, damit sie nicht enttarnt und gelöscht werden. Dies kann durch Schutzmechanismen der Plattformen (automatische Erkennung) geschehen oder über das Melden von Accounts durch die Nutzer.

Social Bots kann man auf vorgefertigten Plattformen steuern. Einfache Benutzeroberflächen und eine gute Bedienbarkeit machen so Bots auch für jene nutzbar, die sich mit Programmieren nicht auskennen. So ein Dienst lässt sich für unter 40 Euro im Monat mieten, es gibt zahlreiche Anbieter auf dem Markt. Deutlich elaborierter geht es mit eigenen Skripten und eigenen Entwicklern, die passgenau das Verhalten der Meinungsroboter programmieren. Idealerweise werden die Bots auch nur zu bestimmten Ereignissen vermehrt eingesetzt. Eine aktuelle gemeinsame Studie dreier Universitäten zum Thema Politische Bots zeigt, dass die Meinungsbots für Trump etwa beim ersten TV-Duell oder am Wahltag besonders aktiv waren. Also immer dann, wenn es darauf ankommt.

Fake-News

Falsche Nachrichten oder „Fake News“ sind kein neues Phänomen, sie sind unter Namen „Zeitungsenten“ oder „Tatarenmeldungen“ schon seit dem 19. Jahrhundert in Deutschland bekannt.

Falschmeldungen können unterschiedliche Hintergründe haben:

Ein häufiger Grund ist schlechte Recherche, Irrtümer und/oder fehlerhafte Darstellung von Zusammenhängen durch Journalisten. Falschmeldungen können aber auch eine Spielart von Satire wie beim Postillion oder The Onion sein. Bei Aktionen der Kommunikations- und Medienguerilla gehören Falschmeldungen zur Tagesordnung. Oftmals werden hier Journalisten durch gezielte Fakes (falsche Webseiten, falsche Pressemitteilungen, falsche Pressesprecher) zu falscher Berichterstattung verführt. Das bekannteste Beispiel hierfür ist der Dow-Chemical-Hack der Yes Men.

Eine weitere Variante sind bewusst falsch dargestellte „Nachrichten“ mit dem Ziel, die Öffentlichkeit für bestimmte politische und/oder kommerzielle Ziele zu manipulieren. Hierzulande gehören zum Beispiel die zahlreich auftauchenden Falschmeldungen über Asylsuchende zum Repertoire einer fremdenfeindlichen Fake-News-Strategie. Als politische Beeinflussung sind auch die Fake-News zu sehen, die aus dem unmittelbaren Umfeld von Trump im Wahlkampf lanciert wurden.

Zudem gibt es kommerzielle Fake-News, die als Clickbait möglichst weite Verbreitung erlangen sollen, damit die Ausgangsseiten der falschen Nachrichten Werbeeinnahmen generieren. Dies war bei den mazedonischen Fake-Seiten der Fall, die im US-Wahlkampf für Trump agierten. Einen ähnlichen Fall recherchierte die New York Times, die Fake-News-Geschäftemacher im georgischen Tiflis porträtierte.

Eine weitere Variante, die vor allem Facebook betrifft, sind News bei denen der Anreissertext auf dem sozialen Netzwerk abgeändert wird. Eine Nachricht eines Mediums bekommt dann auf Facebook einen anderen Drall, den die Nachricht selbst gar nicht einlösen muss. Dies kann aus politischen Motiven geschehen oder aus kommerziellen, wie Boris Rosenkranz der Huffington Post nachwies, die auf Facebook Rassismus als Clickbait nutzte.

Die Verbreitung von Fake-News ist dabei auch der Nutzungsweise von Sozialen Netzwerken geschuldet: Viele Menschen lesen einen 140-Zeichen-Tweet mit Link zu einer Nachricht – und retweeten diesen ohne die Nachricht gelesen zu haben oder der Urheber des Tweets zu kennen. Auf Facebook ist das ähnlich: Likes werden gesetzt, obwohl nur Überschrift und Teaser gelesen wurden. Dabei belohnt Facebook die Viralität von Nachrichten: Alles, was viel Interaktionen und Klicks bringt, wird noch besser verbreitet und noch mehr Menschen in die Timeline gespült.

Gefährliche Debatte um die Bekämpfung von Fake-News

Generell birgt die Diskussion um falsche Nachrichten sehr viele Fallstricke. Viele Menschen nehmen Nachrichten als falsch wahr, wenn sie nicht ihrer Erwartung oder Meinung entsprechen. Andere nehmen sie als falsch wahr, weil Nachrichten angeblich die „Systemmeinung“ wiedergeben, wie man an der Lügenpresse-Debatte beobachten kann. Was wahr oder falsch ist, entspricht also auch der subjektiven Einordnung der Rezipienten und dem Vertrauen in Medien. Bei all diesen Einordnungen in falsch und wahr spielt die tatsächliche Faktentreue der Nachricht oft keine Rolle. Und das ist dann tatsächlich ein Problem.

Ausgehend von der Tatsache, dass es keine Objektivität oder Wahrheit gibt, aber überprüfbare Fakten, kann auch ein vollkommen subjektiv geschriebener Artikel, richtig und wahrhaftig sein. Genauso kann ein Artikel, der von sich sagt, dass er objektiv ist und der in einem objektiven Stil geschrieben ist, Fakten verzerren oder falsch darstellen. Hier kann Transparenz helfen: Wer schreibt eigentlich da? Was will das Medium? Wem gehört es? Was sind die Quellen, aus denen diese Nachricht entstanden ist?

Auf jeden Fall ist klar: Es gibt keine eindeutige Definition, was Fake-News sind. Niemand kann ernsthaft von sich behaupten, dass er Nachrichten in wahr und falsch einordnen kann. Algorithmen werden das Problem nicht lösen. Autoritäre Systeme werden die Debatte um Fake-News nutzen, um ihr nicht genehme Nachrichten zu unterdrücken. Die Debatte birgt große Gefahren für die Meinungs- und Pressefreiheit und kann zu Zensur führen.

Lösungansätze gegen automatisierte Propaganda und Fake-News

Die gesteuerte Beeinflussung der Meinungsbildung schafft Misstrauen in Medien, Politik und Technik. Doch statt neuer Regelungen und Verbote, gibt es heute schon einfache Mittel, welche die Wirkung von Bots und Fake-News zumindest einschränken können.

Was können Journalisten tun?

Mehr Medienkompetenz bei der Einschätzung sozialer Medien brauchen nicht nur die Otto-Normal-Nutzer, sondern vor allem auch Journalistinnen und Journalisten, weil sie als Verstärker wirken. Bei der Berichterstattung über soziale Netzwerke ist also Vorsicht geboten:

- Journalisten müssen bei der populär gewordenen Form der „Das sagt das Netz“-Berichterstattung besser aufpassen. Aussagen wie „Anhänger von XY ließen den Hashtag #XYgewinnt über 18 Stunden trenden“ sind nichts wert, wenn man nicht weiß, ob es sich um echte Anhänger oder Bots handelt.

- Mit Zahlen in sozialen Medien sollte man sowieso extrem vorsichtig sein. Unter den Followern/Freunden können sich zahlreiche Fake-Follower oder Bots befinden. Die reine Zahl sagt also erstmal recht wenig aus, ob Politikerin A beliebter als Politiker B ist.

- Follower, Facebook-Likes, Youtube-Views und vieles mehr kann man sich im Netz für wenig Geld kaufen. Zahlen sagen also wenig aus. Und man kann die Follower auch für andere Leute/Parteien/Unternehmen kaufen, um diese dann als „Faker“ zu diskreditieren.

- Die Ergebnisse der allseits beliebten Online-Umfragen sind meistens nichts wert, weil sie sowohl manuell durch Interessensgruppen wie maschinell durch Bots manipuliert werden können.

- Das Offenlegen von Quellen durch Verlinkungen oder die Veröffentlichung von Originaldokumenten macht die Nachricht für den Leser überprüfbar.

Wie können Nutzer Bots erkennen?

Es gibt verschiedenen Anzeichen, die auf einen Bot hinweisen können:

- Der Name des Accounts: Oftmals haben die Bots Accountnamen, die nach Zufallsgenerator aussehen. Das muss aber nicht so sein.

- Die Anzahl von täglichen Postings ist ungewöhnlich hoch oder hat eine Regelmäßigkeit, die ein menschlicher User nicht leisten könnte. Nur wenige Leute twittern immer zur gleichen Zeit und im immer gleichen Abständen.

- Können die Accounts, wenn man sie anschreibt vernünftig antworten? Machen die Postings und Tweets beständig Sinn oder schleichen sich Fehler ein, die auf eine Automatisierung hinweisen?

- Einen Blick auf die Follower werfen: Folgen einem deutschsprachigen Account nur Accounts, die andere Sprachen nutzen, könnte dies auf Fake-Follower hinweisen. Ungewöhnliche Follower sind oft auf den ersten Blick erkennbar.

- Eine Analyse ihrer Follower und denen, die sie folgen. Bots folgen sich in der Regel gegenseitig und habe wenig/keine echten Freunde. Eine Auswertung des Netzwerkes, die allerdings Programmkenntnisse benötigt, kann Botnetze entlarven, weil die meisten Bots in Botnetzen sich vor allem selbst folgen.

Was können politische Parteien tun?

Parteien könnten eine freiwillige Selbstverpflichtung unterschreiben, dass sie keine meinungsverstärkenden Bots im Wahlkampf einsetzen. Hierbei bleibt natürlich die Gefahr, dass einige Parteien nicht mitmachen oder dass diese Bots nicht offiziell einsetzen, es aber unter der Hand doch tun. Bei versteckter Wahlkampfunterstützung hat gerade die rechtspopulistische AfD Erfahrung. Andererseits können sich Parteien schwer dagegen wehren, wenn irgendjemand Bots für sie einsetzt.

Und Parteien sollten selbst nicht an Fakten vorbei Politik machen: Wir leben in Zeiten, in denen zwei Drittel der Deutschen die Kriminalitätsentwicklung vollkommen falsch einschätzen. Doch Innenpolitiker berufen sich auf dieses „subjektive Unsicherheitsgefühl“, um immer neue Überwachungsinstrumente durchzusetzen. Das ist eine Politik, die nicht auf Empirie und Evidenz setzt, sondern auf Gefühle und gesellschaftliche Fehlannahmen.

Was können soziale Netzwerke und Plattformen tun?

Soziale Netzwerke können die Erkennung von Bots und Botnetzen verbessern. Sie müssen dabei darauf achten, dass sie nützlichen Bots nicht schaden. Dass in Sachen Fake-News ausgerechnet Facebook die Rolle zukommen soll, zwischen wahren und falschen Nachrichten zu unterscheiden, kann niemand wollen, dem freie Meinungsäußerung ein wichtiger Wert ist. Es gibt Hinweise, dass Facebook an einem Zensurtool arbeitet, dass für den chinesischen Markt bestimmt ist. Das weist darauf hin: Dem Unternehmen ist egal, wo es seine Profite macht und unter welchen politischen Voraussetzungen.

Wichtig ist jetzt vor allem, dass Facebook nicht anfängt „falsche“ Nachrichten auf Einzelaccounts zu zensieren oder ihre Verbreitung verhindert. Stattdessen könnte Facebook in vom Unternehmen selbst kuratierten Angeboten dafür sorgen, dass dort seriöse Quellen und Nachrichten verbreitet werden. Dass Facebook diese Trending News beeinflussen kann, hat es ja in der Vergangenheit gezeigt. Genauso kann das Unternehmen überlegen, ob es sinnvoll ist, dass jede dahergelaufene Fake-News-Seite mit „Instant Articles“ das gleiche Design bekommt wie seriöse Medien. Dafür wird Facebook Leute brauchen, die das preisgekrönte Bild vom Napalm-Mädchen von Kinderpornografie und die qualitativ hochwertige investigative Recherche von der billigen Fake-News unterscheiden können, wie Margaret Sullivan von der Washington Post treffend schreibt.

Wie können Nutzer Fake-News erkennen?

Bei einer bestimmten Gruppe von Menschen wird ein Appell an die Eigenverantwortung zur Überprüfung von Nachrichten nicht helfen. Sie posten, was in das vorgeformte Weltbild passt. Da ist es egal, ob die Nachricht nun komplett frei erfunden, ob sie von unseriösen Medien wie der Epoch Times aufgebretzelt oder von Rechtsradikalen mit falscher Überschrift auf Facebook gepostet wurde.

Bei anderen Menschen helfen die simpelsten Werkzeuge der Medienkompetenz und ein bisschen Suchmaschinenbedienung:

- Nachrichten auf Plausibilität zu prüfen, bevor man auf „Teilen“ klickt

- gibt der Artikel eine Quelle an? Ist diese verlinkt und überprüfbar?

- gibt es andere Quellen, welche die Nachricht bringen?

- berichten auch angesehene Medien darüber?

- Wer verbreitet eigentlich die Nachricht? Wen teile oder retweete ich eigentlich da? Welche anderen Inhalte verbreitet der Ursprungsaccount?

Fact-Checking-Webseiten (hier eine Studie über diese) und Anti-Fake-Webseiten helfen dabei, herauszufinden und publik zu machen, ob eine Nachricht gefälscht ist. Im schnellen Strom der Nachrichten und bei den begrenzten Mitteln der Fact-Checker ist das nur für einen Teil der Nachrichten möglich. Und wie das schon immer mit der Richtigstellung von „Enten“ war: Sie erreichen nie eine so große Leserschaft wie die schrille Nachricht, die sie dementieren. Treffend besungen hatte das vor Urzeiten einmal Reinhard Mey in seinem Song „Was in der Zeitung steht“.

Was kann der Staat tun?

Der Bundes- und Landesregierungen müssen das Thema Medienkompetenz auf die Agenda setzen. Das geht mit der Schule los und hört mit der Weiterbildung aller gesellschaftlichen Alterstufen auf. Das kostet Geld. Solange in den Bundesländern bisher nur einige Cent pro Bürger und Jahr dafür zur Verfügung stehen, wird es nicht klappen, diese neuen Herausforderungen für die Demokratie zu meistern.

Die CDU will, dass hinter jeder Meinung ein Mensch steht, und keine Maschine. Es sieht schwer danach aus, dass dies nicht funktionieren wird. Wenn das also nicht funktioniert, muss man erstmal dafür sorgen, dass die Menschen die Maschinen erkennen und die Fähigkeit haben, die allerschlimmsten Falschmeldungen von faktentreuen Nachrichten zu unterscheiden.

An Hinweisen zum Einsatz von Social Bots und anderen hier genannten Techniken im politischen Betrieb, in Public Relations oder von staatlichen Akteuren sind wir für die weitere Berichterstattung sehr interessiert. Bitte nutzen Sie die üblichen Kanäle zur Kontaktaufnahme.

Die CDU moechte vor allem, dass hinter jeder Meinung ein ihr wohlgesonnener Mensch oder ein verklagbarer Mensch steht. Die SPD moechte Meinung im Internet am liebsten so regulieren wie Rundfunk, denn mit Gremienmauscheln kennt sie sich aus und die Bevoelkerung muss schliesslich beschuetzt werden.

Ich ziehe eine ehrliche Maschine einem unehrlichen Menschen vor, und einen nachvollziehbar faktenbasierten automatisch erstellten Artikel einem manipulativen oder einfach falschen manuell erstellten.

„Eine ehrliche Maschine“, die unehrlichen Absichten von unehrlichen Menschen folgt ist…… – na raten Sie mal.

Es geht um Deutungshoheit……Propaganda machen beide Seiten, man muss den wahren Hintergrund kennen z.B in Syrien es geht nur um Erdgas und Piplines nicht um Menschen, Demokratie etc.. Syrien ist wie ein Sperr Riegel zum Mittelmeer und jetzt gibt es Katar und Iran die auf der grössten Gas Vorkommen der Welt sitzen South-Pars-Gasfeld. https://de.wikipedia.org/wiki/Liste_der_weltweit_größten_Gasfelder

Und jetzt wird von den Mächten mit allen schmutzigen Tricks gearbeitet….Internet, Medien….jeder versucht seine Version zu erzählen, es geht aber wie immer nur um Herrschaft, macht, Pfründe…und genau darum geht es unseren Eliten auch nur.

Das Problem ist ja das ich bei ARD, ZDF und NT V meistens was vorgekautes bekomme…..eine typische Meinungsmache…..ich möchte aber selber recherchieren, deshalb schaue ich mir auch die russische Propaganda an…..aus der Propaganda beider Seiten kann man im Grunde erst die echte Wahrheit erfahren.

http://www.wiwo.de/politik/ausland/fluechtlingskrise-ausloeser-allen-uebels/12310284-2.html

Unsere Politiker geht es um Bürger Manipulation….wir sollen galuben was man uns serviert. Herr Kauder hat ja eindruckvoll bewiesen……was er meint:„Wenn das Netz weiter lügt, ist mit Freiheit Schluss!“

Wer bestimmt was Wahrheit oder Lüge ist? Das Wahrheitsministerium?

Manipulieren tun alle alle tun das. Ob Links, rechts oder Geheimdienste, Sekten. Auch Wikipedia wird manipuliert gerne mal von Geheimdiensten und selbsternannten Gutmenschen (die dunkle Seite der Wikipedia)

Im Grunde ist es ein Wettbewerb, wie beim Fussball. Das Internet ist nur die Spielwiese. Jetzt spielen aber Training, Spieler, Geld, Bestechung, etc. eine grosse Rolle.

Was die Politik und Mächtigen ist, das sie keine Kontrolle haben wie autokratische Regime, jetzt wollen sie aber genau das gleiche. Im Grunde wird unser Internet dann das gleiche wie in China sein, nur ist die Verpackung dann so nett, das es viele nicht merken. Für die Jugend werden ja von den Medienkonzerne schon eifrig Formate gestrickt, sehr geschickt wird dort politisch Einfluss genommen über eine Lifestyle Oberfläche.

Verkürzt. Das Internet ist kaputt.

Das Internet ist noch ziemlich heile, auch wenn das viele stoert.

Journalisten sollten vor allem erstmal vor der eigenen Haustür kehren, da auch seriöse deutsche Medien Spam-Bots einsetzen, die ihre Meldungen pushen.

Wenn Sie da handfeste Belege haben, dass Verlage diese wirklich selbst einsetzen und steuern, dann freuen wir uns über eine Mail von Ihnen.

Tja Belege, aber nur beispielhaft mal nach „Jetzt kann auch im Winter Beton produziert werden“ bei Twitter suchen. Allein die Namen der angeblichen Personen sind so offensichtlich gefakt. Posten die ganze Zeit nur solchen Kram, folgen sich gegenseitig etc. Dahinter wird irgendeine Agentur stecken. Wer die letztlich bezahlt – keine Ahnung – Recherche fällig ;-)

Das sehe ich auch so er US Wahlkampf hat doch gezeigt wie schmierig Journalisten arbeiten und gottseidank sind sie auf die Fresse geflogen.

Aber anstatt selbstkritik zu üben…verschwören sich die Meinungsmacher mit der abgehalfterten Politik Elite und würden am liebsten das Internet durchzensieren und unter staatlicher Aufsicht stellen. Das ist keine Demokratie das ist Plutokratie oder Feudalismus.

Das ist doch auch wieder so eine Vereinfachung samt Medienverschwörung, die keinem weiterhilft. Vor allem benennt das keine echten Missstände, sondern verdeckt sie mit Pauschalurteilen.

Anmerkung der Moderation: Dieser Kommentar wurde gelöscht, weil darin Behauptungen ohne jegliche Quellenangabe aufgestellt wurden. Bitte belegen Sie, was Sie sagen. Nur so ist eine sinnvolle und für alle fruchtbare Diskussion möglich.

Die Erklärung für unerwünschte Wahlergebnisse ist ganz einfach. Erhebliche Teile der Bevölkerung, nicht nur in Deutschland, sehen, dass sie die vergangenen 20 Jahre nur verarscht wurden. Die würden jeden „wählen“, aber keine der Parteien, die heute noch im Bundestag dummes Zeug schwätzen. All diese Bots, Fakes und Trolle sind gegen diese Ablehnung unbedeutend. Denn den 24% AfDisten in Sachsen Anhalt war das Internet samt Twitter oder Fratzenbuch eher Wurst. Die größten Wahlverlierer waren Linke, Grüne und Rote, nicht etwa die Kanzlerinnenpartei. Das wird sich nicht ändern, denke ich.

Merke: Trolle sind stets die Russen!

Zeit Online: Ein Lehrstück über Propaganda:

Wir befinden uns im Krieg. Gegen das übermächtige Russland. Der BND kämpft für uns. Mit Information gegen Desinformation:

„Der Bundesnachrichtendienst überwacht verstärkt die russische Propaganda. Dazu hat der BND eine eigene Arbeitsgruppe gegründet. Sie soll die Bundesregierung unter anderem mit Informationen über russische Trollarmeen und deren Propagandaaktionen versorgen. Spätestens seit dem Beginn des Krieges in der Ukraine habe die Bundesregierung „aufmerksam“ die Aktivitäten der russischen Medien beobachtet, sagte die stellvertretende Regierungssprecherin Christian Wirtz am 19. Februar. Man sehe „durchaus auch an einzelnen Stellen eine tendenziöse Berichterstattung“.(…) Für Russland ist die Bundesrepublik in diesem sogenannten hybriden Kampf ein wichtiges Ziel.“

Unabhängig vom Grad des russischen Trollfaktors und den fragwürdigen Demokratieexporten mancher westlicher Think Tanks und Stiftungen, offenbart die Skandalisierung der ZON Journalisten ein hohes Maß an Bigotterie. Staatlich finanzierte und organisierte Propaganda ist mitnichten ein primär russisches Phänomen. Täuschung, Verschleierung, Desinformation, die Verbindung von verdeckten und offenen Operationen, von diplomatischem Druck und wirtschaftlichem Zwang, von Desinformation und Cyberattacken, das Hochfahren von Propagandasendern, das Ineinandergreifen von militärischen und zivilen Mitteln, das Verwischen von Krieg und Nichtkrieg sind erprobte Mittel von Großmächten. Es ist hinlänglich bekannt, dass die USA und das von ihnen dominierte Militärbündnis NATO diese sogenannte hybride Kriegsführung zur Perfektion gebracht haben.

https://machtelite.wordpress.com/2016/03/08/zeit-online-ein-lehrstueck-ueber-propaganda/

„Eine Regierung stellt eine Agentur an, die koordiniert in Kommentaren auf Medienseiten oder in sozialen Medien die Position der Regierung vertritt oder Kritik an der Regierung zerstreut. Im Fall Russlands beschreibt dieser Wikipedia-Artikel dieses Vorgehen detailliert.“

Und wer koordiniert Wikipedia?

https://machtelite.wordpress.com/2015/10/28/die-dunkle-seite-der-wikipedia-wie-kopilotjesusfreund-und-co-911-artikel-saeubern/

ein modell auch für/in dld ? blick nach italien wg. kommendem sonntag referendum – Italy’s Most Popular Political Party Is Leading Europe In Fake News And Kremlin Propaganda

The Five Star Movement controls a network of official sites and supposedly independent news outlets that spread misinformation across the internet.

https://www.buzzfeed.com/albertonardelli/italys-most-popular-political-party-is-leading-europe-in-fak

–

Riding Trump wave, Breitbart News plans U.S., European expansion –

http://www.reuters.com/article/us-usa-election-trump-strategy-idUSKBN1342TP

wir verbreiten falschinformationen seit tag eins. warum? weil wir können

leider wurde ein hinweis auf die dem social graph innewohnenden probleme vermieden. Elli Pariser hat kuerzlich auf den zusammenhang von fakenews und filterbubble nochmal hingewiesen. der „confirmation bias“ ist das grundproblem, selbst wenn zweifelhafte domains, und spamartige bot attacken technisch noch halbwegs filterbar sind, so ist das problem der homogenen meinungsblasen (echokammer) die kernursache beim „hochsexen“ von selbst-bestaetigenden nachrichten zweifelhaften ursprungs. facebook ist darauf optimiert den nutzer moeglichst lange an die plattform zu binden. stoerende politische gegenmeinungen sind dabei per algorithmus und datenstruktur zu vermeiden. das collaborative filtering in privater hand fuehrt zu mehr sozialer homogenitaet (normcore) und selbstoptimierungswahn, dessen symptom die anfaelligkeit fuer fakenews mit sich bringt.

Der Artikel war schon so umfassend. Deshalb habe ich vermieden, dieses Fass auch noch aufzumachen. Aber klar: Das gehört auch zum Themenfeld.

Auf reddit hat sich eine Gruppe gebildet, die Martin Schulz als kommenden Bundeskanzler anpreist. Das ist nicht sehr seriös aufgemacht und gibt selbstironisch an, eine Parodie auf den Trump-Subreddit zu sein, indem im Zangendeutsch populäre Schlagworte übernommen oder leicht variiert werden und mit Memes versehen werden.

Ich bin unschlüssig, wie ich das Geschehen dort einordnen soll… Trolle? Bots? Satire? Propaganda? Überzeugungstäter? Gekaufte Lemminge? Vor dem Hintergrund der Nachricht, dass Frau Kraft angeblich schon wissen will, wer der Kanzlerkandidat der SPD wird und eingedenk der Tatsache, dass es keinen solchen äquivalenten Subreddit zu Gabriel oder Merkel gibt (wohl aber zu Petry und Hofer), entsteht die Vermutung, dass parteiintern bereits die Werbemaßnahmen in Kraft getreten sind. Zweifelhaft ob die Ankündigung im Januar dann noch überraschen wird.

Nichtsdestotrotz ist es faszinierend, trotz Ungewissheit.

Fazit des Artikels: das Internet ist kein demokratisches Medium, weil angebliche Meinungsäußerungen massenhaft manipuliert werden – und daran lässt sich nichts ändern, denn der Fehler liegt tief „im System“. Es gibt auch keine Lösung – außer einem kompletten Reboot – höchstens noch richtige Konsequenzen.

Niemand braucht Facebook, Twitter, Youtube oder Google. Alle diese Dienste können sofort abgeschaltet werden, es dauert keine drei Wochen, schon wird der nächste Anbieter genau dasselbe leisten – das ist zwar auch keine Lösung, aber wenigstens eine richtige Konsequenz. Meinen Facebook-Account habe ich gelöscht und nutze keinen der genannten Dienste mehr.

Wir haben die Wahl, ob wir trotz all unserer verführerischen Technik-Gadgets wieder zur Vernunft zurückkehren, oder ob wir dies erst tun, nachdem irgendein Trumpel auf den roten Knopf gedrückt hat.

Das Netz in der heutigen Form ist technisch nie sicher (TCP+HTML), es findet keine wirkliche Regulierung nach rechtsstaatlichen Prinzipien statt, es gibt keine angemessene Vergütung für die Bereitstellung von Inhalten und keine journalistische Verantwortung für Nachrichtenmeldungen. Bereits vor 15 Jahren war es erkennbar, als Napster und PirateBay unter dem Applaus des desinformierten Pöbels (Piraten) ungestört unser musikkulturelles Erbe plündern konnten, nun ist es wohl offensichtlich: das Netz ist kaputt – lang lebe ein anderes Netz, das bislang noch nicht geschaffen wurde. Bis dahin empfehle ich Smartphones und alle anderen Datenschleudern (Autos) zu meiden und die toxischen, modernen „Volksempfänger“ dem Pöbel zu überlassen.

[kleine Info zur Person: habe 1995 mit großer Euphorie das erste Internetcafe in meiner Stadt eingerichtet, bin Programmierer und Netznutzer der ersten Stunde, fühle mich aber ohne Smartphone pudelwohl und erfreue mich in glücklichen Offline-Zeiten daran, Bücher zu lesen, Klavier zu üben und die finstere Netzrealität zeitweise zu vergessen]

Und unter welche der oben genannten Kategorien fällst Du? Auf jeden Fall bist Du von der Regierung gesteuert. Zitat:

„es findet keine wirkliche Regulierung nach rechtsstaatlichen Prinzipien statt,“

Genau das ist es was das Netz noch kaputter machen würde. Denn das was zur Zeit als rechtstalltiche Eingriffe sprich Regulierung angedacht wird ist nichts als Zensur. Jede abweichende Meinung soll als Hatespeech oder Populismus oder Extremismus verboten werden. Egal ob von rechts oder links.

Zitat:

„es gibt keine angemessene Vergütung für die Bereitstellung von Inhalten“

Wieso nicht? Es gibt Paywalls, Werbung vom eigenen Server statt von trackenden Werbenetzwerken, und Spenden. Wenn die Vergütung Deiner Inhalte nicht Deinen Vorstellungen entspricht könnte die an der falschen Strategie zur Vergütung,an Mangelnder Qualität liegen, oder überzogenen Vorstellungen zur höhe der Vergütung liegen..

Zitat:

und keine journalistische Verantwortung für Nachrichtenmeldungen.

Die gibt es genauso wenig oder stark wie in den Printmedien oder im Fernsehen. Dafür hat man aber die Möglichkeit verschiedenen Quellen mit unterschiedlichen Darstellungen zur Bildung der eigenen Meinung zu nutzen. Ein unschätzbarer Vorteil. Aber schon richtig, die Regierenden verlieren so ihre Deutungshoheit.

Zitat:

Bereits vor 15 Jahren war es erkennbar, als Napster und PirateBay unter dem Applaus des desinformierten Pöbels (Piraten) ungestört unser musikkulturelles Erbe plündern konnten

Das stellt den Gipfel der Verunglimpfung und für mich den engültigen Beweis dar, das es sich bei Deinem Beitrag um eben genau das dreht was der Artikel beschreibt. Ja gut gemacht aber trotzdem. Die Piraten werden als desinformierter Pöbel verunglimpft, dabei sind sie die einzige Partei die in Sachen Internet Kompetenz haben. Die Bösen Raubmodrkopierer plündern jetzt schon das kulturelle Erbe. Schlimmer geht nimmer. Auch zu meiner Jugend waren 99% der Musiksammlung kopiert, damals eben auf Kasetten. Und es gab Radiosendungen die versprochen haben jeden Titel vom ersten bis zum letzten Ton zu spielen ohne drauf zu Quatschen. Aber ein Rundfunksender kann sich halt juristisch besser wehren wie ein Schüler der von der Contentmafia auf zehtausenden € Schdenersatz verklagt wird. Anstatt den Konsumenten die Schuld zu geben sollte man vielleicht wieder auf echte gewachsene Musiker und Bands setzen. Mal als Denkanstoss: Warum verkaufen Musiker/Bands mit einer Besetzung im Rentenalter riesige Hallen und Stadien innerhalb von Minuten aus, während die gehypten Neuküstler schon bei der dritten Tournee Konzerte absagen müssen weil sie sie nicht gefüllt bekommen? Weil sie einzigartig und wiedererkennbar sind? Eben nicht von Managern nach Marketigkriterien ausgewählt und nach 2 Jahren fallen gelassen, weil es einen neuen Trend gibt?

Wer täglich Hetze und Falschmeldungen haben will, braucht nur im Fernsehen, 1. Reihe, Nachrichten ansehen. All die anderen Medien dürften dagegen bedeutungslos sein.